HBM de próxima generación se centra en núcleos de GPU integrados

- Masterbitz

- 26 nov

- 2 Min. de lectura

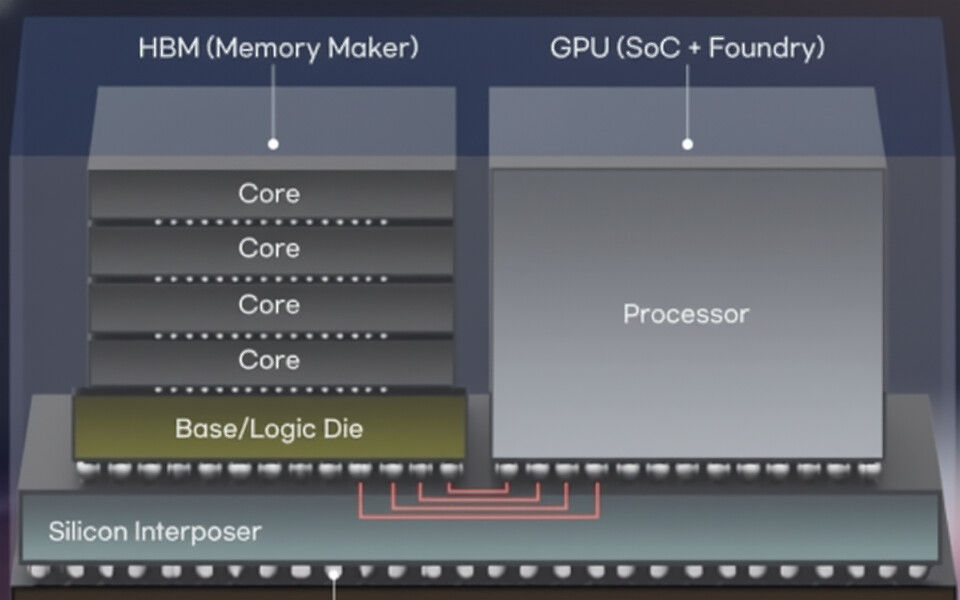

Las empresas de tecnología están explorando un cambio importante en el diseño de HBM que busca incrustar núcleos de GPU directamente en las pilas de memoria de próxima generación. Según informes de la industria coreana, Meta y NVIDIA están evaluando "HBM personalizado" arquitecturas que integran núcleos de GPU en el dado base de los futuros dispositivos HBM, con SK Hynix Y Samsung dijo que estaba involucrado en las primeras discusiones. HBM apila múltiples matrices de DRAM en la parte superior de una matriz de base que maneja E/S externa. Se espera que HBM4 alcance Producción en masa El próximo año incluirá un controlador a bordo para mejorar el ancho de banda y la eficiencia. La integración de los núcleos de la GPU llevaría este concepto varios pasos más allá, distribuyendo el cálculo en la propia memoria para reducir el movimiento de datos y reducir el uso de energía. Fuentes de la industria dicen que el enfoque podría aumentar tanto el rendimiento como la eficiencia energética para las cargas de trabajo de IA al reducir la distancia entre la computación y la memoria. Pero el diseño todavía enfrenta grandes dificultades, como el área de troquel limitada en pilas basadas en Through-Silicon Vias (TSV), las restricciones de entrega de potencia y la dificultad de enfriar esa lógica de GPU informática dentro de la matriz base.

.png)

Comentarios