NVIDIA actualiza el ancho de banda de la memoria "Vera Rubin" antes del lanzamiento del AMD Instinct MI400

- Masterbitz

- 20 ene

- 2 Min. de lectura

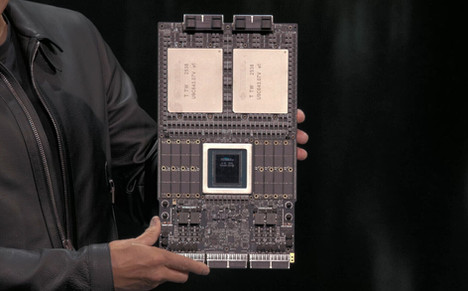

Como anticipamos los primeros envíos de "Vera Rubin" de NVIDIA A finales del verano, se ha informado que NVIDIA actualizó su superchip varias veces desde marzo para competir mejor con la próxima serie de aceleradores Instinct MI400 de AMD. Según SemiAnalysis, el objetivo inicial de NVIDIA para el sistema "Vera Rubin" VR200 NVL72 fue de 13 TB/s en marzo, que se actualizó a 20,5 TB/s en septiembre. Sin embargo, en el CES 2026, NVIDIA confirmó que el sistema VR200 NVL72 ahora funciona a 22 TB/s de ancho de banda. En comparación con el acelerador Instinct MI455X de AMD, que tiene 19,6 TB/s, NVIDIA inicialmente tenía un ancho de banda inferior del sistema. Abordaron esto mediante el uso de DRAM más rápida y la mejora de las interconexiones entre las CPU, las GPU y todo el sistema.

En noviembre, AMD comparó la línea MI400 con la próxima serie "Vera Rubin" de NVIDIA, que reclama un rendimiento informático y un ancho de banda de memoria similares, pero 1,5 veces mayor capacidad de memoria y ancho de banda de escala. AMD afirma que entregará hasta 40 FP4 y 20 PFLOP FP8, aproximadamente el doble del rendimiento de cálculo del MI350 actual. Las GPU también hacen la transición a la memoria HBM4 desde HBM3e, aumentando la capacidad de 288 GB a 432 GB y aumentando el ancho de banda total de 8 TB/s a 19,6 TB/s. Cada GPU proporciona 300 GB / s de ancho de banda escalable y agrega soporte de formato de datos de IA más amplio junto con canalizaciones de IA expandidas. Se planifican dos modelos: el Instinct MI455X para la formación e inferencia de IA a gran escala, y el MI430X para HPC e IA.

Para el VR200, NVIDIA ha establecido objetivos de rendimiento de aproximadamente 50 PetaFLOPS de FP4 de computación por GPU Rubin, lo que resulta en aproximadamente 100 PetaFLOPS FP4 para el Superchip de dos GPU. Cada GPU Rubin integra dos chiplets de computación del tamaño de una retícula emparejados con ocho pilas HBM4, proporcionando aproximadamente 288 GB de HBM4 por GPU y aproximadamente 576 GB de HBM4 para el Superchip completo. Sin embargo, dado que estas GPU se venden como sistemas completos, será interesante ver cómo funcionan las soluciones de AMD y NVIDIA y qué opciones hacen los hiperescaladores.

Fuente: SemiAnalysis

.png)

Comentarios